在当今数字化时代,数据已成为企业的核心资产。有效的数据治理不仅关乎合规与安全,更是驱动业务决策与创新的基石。数据处理作为数据治理中的关键环节,贯穿于数据的全生命周期,直接决定了数据的质量、可用性与价值。本文将系统介绍企业数据治理中数据处理的基础知识,包括其定义、核心流程、常见技术与实践要点。

一、数据处理的内涵与重要性

数据处理,广义上指对原始数据(Raw Data)进行一系列操作,以使其转化为适合分析、应用或存储的形式的过程。在企业数据治理的框架下,数据处理是确保数据资产可信、一致、可用和安全的必要手段。其重要性体现在:

- 提升数据质量:通过清洗、转换等手段,消除数据中的错误、不一致和冗余,为分析和决策提供可靠基础。

- 赋能业务应用:将不同来源、格式的数据整合并转化为业务可理解的格式,支撑报表、智能分析、客户洞察等应用。

- 保障合规与安全:在数据处理过程中实施脱敏、加密、访问控制等措施,满足GDPR等法规要求,保护企业与客户隐私。

- 优化存储与成本:通过合理的数据转换、压缩与归档策略,提升存储效率,降低IT成本。

二、数据处理的核心流程

一个完整的数据处理流程通常遵循“采集-加工-服务”的闭环,具体可分为以下几个阶段:

- 数据采集与集成:

- 从各类内部系统(如ERP、CRM)和外部源(如物联网设备、公开数据)获取数据。

- 解决多源异构数据的连接问题,是数据处理的起点。

- 数据清洗与标准化:

- 清洗:处理缺失值、异常值、重复记录,修正格式错误。

- 标准化:统一日期、货币、单位等格式,建立企业级数据标准(如统一的客户编码)。

- 数据转换与整合:

- 转换:根据业务规则进行计算、衍生(如计算客户生命周期价值)、聚合或拆分。

- 整合:将不同主题域的数据关联、合并,形成统一、完整的视图(如360度客户视图)。

- 数据加载与存储:

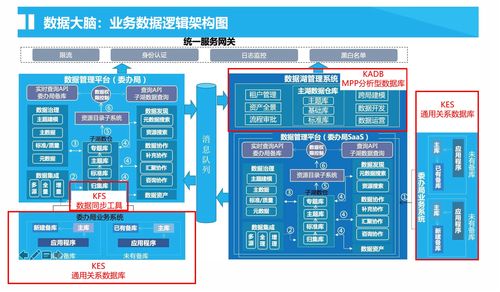

- 将处理后的数据加载到目标存储系统中,如数据仓库、数据湖或业务数据库。

- 需设计合理的存储模型(如星型模型、数据分层)以支持高效访问。

- 数据服务与分发:

- 通过API、数据门户、报表工具等方式,将“就绪”的数据安全地分发给业务用户、分析系统或合作伙伴。

三、数据处理的关键技术与工具

- ETL/ELT:传统的数据集成范式。ETL(提取、转换、加载)在加载前转换,适合数据仓库;ELT(提取、加载、转换)在加载后转换,依托云数据平台的强大计算能力,灵活性更高。

- 数据质量工具:自动化进行数据剖析、监控、清洗和匹配,确保处理结果的可靠性。

- 主数据管理:通过创建和维护企业关键业务实体(如客户、产品)的单一、准确、权威版本,为所有数据处理活动提供“黄金记录”。

- 流处理与批处理:

- 批处理:对一段时间内积累的数据进行周期性处理,适合报表、历史分析。

- 流处理:对持续产生的数据流进行实时或近实时处理,适合监控、实时推荐等场景。

- 数据目录与血缘分析:记录数据的来源、处理过程、变更历史与流向,实现数据处理的透明化和可追溯,是数据治理能力的重要体现。

四、企业实践要点与挑战

- 以业务价值为导向:数据处理项目必须紧密围绕明确的业务目标(如提升销售转化率、优化供应链)展开,避免陷入纯技术活动。

- 建立统一的数据标准与规范:在治理委员会指导下,制定并强制执行数据定义、质量规则和处理流程的标准,这是确保跨部门数据一致性的前提。

- 平衡敏捷与治理:采用迭代式开发,快速交付数据产品或洞察,同时将数据质量检查、安全策略等治理要求嵌入处理流程(“治理左移”)。

- 关注数据安全与隐私:在设计的早期阶段就纳入数据分类、脱敏、加密和访问控制策略,遵循“隐私 by Design”原则。

- 培养数据文化与技能:提升全员(尤其是业务人员)的数据素养,同时为数据工程师、分析师提供持续的技术培训。

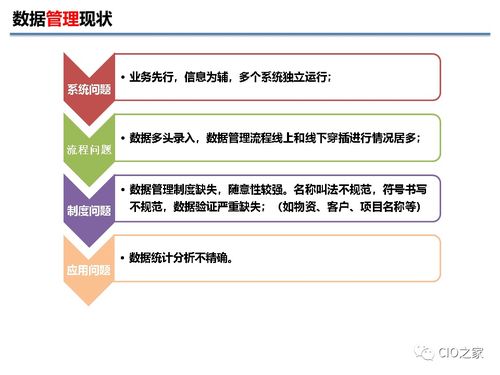

面临的常见挑战包括:数据孤岛难以打破、处理流程复杂且成本高、实时处理需求增长、以及技术选型与人才短缺等。

###

数据处理是企业数据治理从理论走向实践、从管控走向赋能的核心纽带。它并非一次性的技术项目,而是一个需要持续优化、与业务共同演进的动态过程。企业只有建立起规范、高效、安全且灵活的数据处理能力,才能将海量数据真正转化为驱动增长的智慧,在数字竞争中赢得先机。